AMD A8-3850 et A6-3650 : Le pari APU

Publié le 30/06/2011 (Mise à jour le 22/07/2011) par Guillaume Louel

Architecture GPU

Le GPU utilisé dans les APU Llano n'est pas nouveau non plus puisqu'il s'agit ni plus ni moins que de celui utilisé pour la Radeon HD 5570 (Redwood). Il utilise l'architecture vec5 traditionnelle des Radeon HD que l'on a pu vous présenter à maintes reprises, on parle bien entendu d'une puce graphique DirectX 11.

Le GPU inclus dans l'A8-3850 reprend les 5 groupes d'unités SIMD de la puce Redwood ce qui nous donne 80 vec5 (compté en 400 shaders par AMD). Il est cadencé à 600 MHz. L'autre APU lancé aujourd'hui, l'A6-3650 utilise une version légèrement castrée à seulement 4 groupes SIMD, ce qui donne 64 vec5 (320 shaders), la fréquence descend à 443 MHz. Par rapport à Redwood, ce nouveau "Sumo" rajoute l'UVD3, à savoir le décodage accéléré du Mpeg 4 Part 2 (XviD) et du MVC (BluRay 3D)

En ce qui concerne la mémoire, on utilisera exclusivement côté desktop la mémoire principale partagée (jusqu'à 512 Mo). Contrairement aux cartes mères 890GX, l'option "sideport" qui permettait l'inclusion d'une puce mémoire sur la carte mère disparait.

Le GPU est directement relié au contrôleur mémoire 128 bits de Llano, ce dernier est commun et partagé entre processeur et GPU. 32 lignes PHY sont également disponibles. 24 d'entre elles sont transformables en PCI Express, ce qui permet de gérer un port 16x (ou 2x 8x) et un port 4x. Le dernier 4x servant à l'interconnexion avec le chipset. Les 8 lignes supplémentaires sont asservies pour la gestion des écrans.

C'est d'ailleurs ici que les choses se compliquent puisque les options sont nombreuses au niveau de la connectique aux écrans. En théorie, Llano peut gérer jusque 6 écrans, mais seulement deux peuvent être actifs à la fois.

La manière de configurer les sorties des cartes mères varie cependant d'un constructeur à l'autre. Ainsi, tous ne proposent pas forcément un port DVI capable du mode Dual DVI (nécessaire pour les écrans 2560 par 1600 et pour les écrans 120Hz/3D). On trouvera chez la majorité une restriction imposant de ne pas pouvoir utiliser les sorties DVI et HDMI en simultané, liée aux switchs utilisées qui sont souvent communs pour ces deux sorties. Ce n'est pas forcément une obligation (chez Gigabyte par exemple). Bref si vous envisagez le double écran sur une telle plateforme, nous vous conseillons fortement de télécharger à l'avance le manuel de la carte mère que vous comptez acheter.

Mémoire partagée, bande passante CPU <-> GPU

Nous avons tenté de mesurer l'influence de la bande passante mémoire sur les transferts CPU <-> GPU, qui sont en réalité des transferts mémoire centrale<->mémoire vidéo, mais dans des espaces différents. Nous avons utilisés pour cela une application OpenCL que nous avions déjà utilisée dans notre article sur le PCI Express.

Les scores que vous pouvez comparez à ceux d'une carte graphique dédiée sur cette page (mémoire paginable, en bas) sont dans l'absolu plutôt bon, on retrouve des scores un peu au dessus de ceux que l'on obtient via un port 8x. Si augmenter la bande passante mémoire au-delà de 1333 MHz apporte un gain, ce dernier reste plus mesuré. Notez que lors de l'AFDS, AMD a évoqué la possibilité d'éviter les copies mémoires inutiles par le biais d'un mécanisme dans le driver, un sujet sur lequel nous reviendrons dans un autre article.

Mémoire partagée, influence pratique

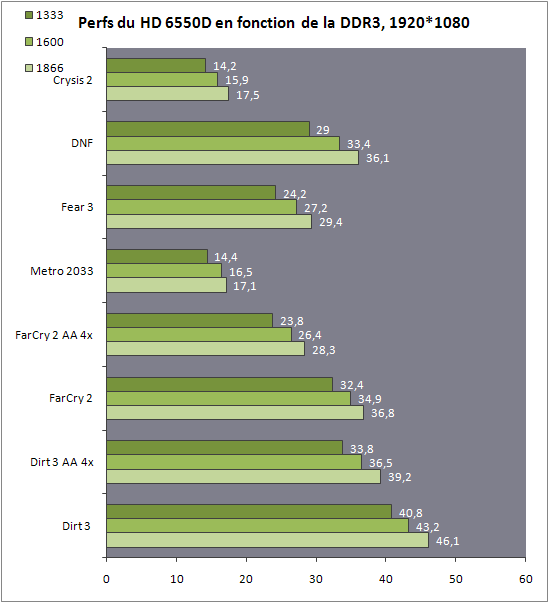

Nous avons regardé l'influence de la bande passante mémoire partagée en pratique sur les performances de la puce intégrée à l'APU A8-3850.

Passez la souris sur le graphique pour voir sous forme d'indice

Quel que soit le jeu utilisé, les gains sont relativement constants. Ainsi passer de la DDR3 1333 à la DDR3 1600 augmente les performances d'environ 10%. La DDR3 1866 MHz peut faire grimper cet écart à près de 20% selon les titres. Cela montre une fois de plus les très bonnes prestations du nouveau contrôleur mémoire intégré à Llano, même s'il faut rappeler qu'a l'heure ou nous écrivons ces lignes, la DDR3-1866 rajoute un surcout d'environ 20 euros par rapport à de la mémoire plus classique.

CPU vs IGP

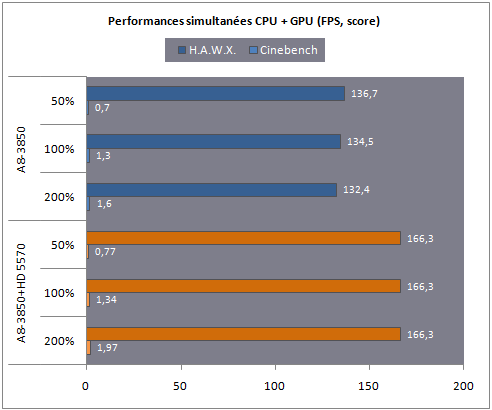

A l'image de ce que nous avions réalisé pour le test de Sandy Bridge, nous avons voulu vérifier l'évolution des performances graphiques en fonction de la charge processeur, un point faible de l'architecture d'Intel (voir ici pour le Core i3).

Passez la souris sur le graphique pour voir sous forme d'indice

Seules les performances CPU baissent lorsque l'on joue, ce qui est le comportement attendu. La priorité est donnée au jeu en premier plan dont les performances restent quasiment inchangé. AMD donne la priorité au GPU dans son contrôleur graphique, contrairement, on l'imagine (nous attendons toujours une réponse de la part d'Intel pour le problème relevé dans les Core i7, puis i3, nous savons simplement qu'ils ont reproduit et confirmé le problème en interne) à celui d'Intel.

Sommaire

1 - Introduction

2 - Architecture CPU, nouveau contrôleur mémoire

3 - Architecture GPU, mémoire partagée

4 - La plateforme, Dual Graphics

5 - CPU : Cinebench, x264

6 - CPU : 7-Zip, MinGW

2 - Architecture CPU, nouveau contrôleur mémoire

3 - Architecture GPU, mémoire partagée

4 - La plateforme, Dual Graphics

5 - CPU : Cinebench, x264

6 - CPU : 7-Zip, MinGW

Vos réactions

Contenus relatifs

- [+] 17/03: AMD baisse ses prix AM3+/FM2+

- [+] 06/04: AMD pré-annonce Bristol Ridge

- [+] 13/05: AMD baisse les prix des Kaveri

- [+] 04/06: Computex: AMD lance les Kaveri mobi...

- [+] 17/03: L'AMD A8-7600 se fait attendre

- [+] 21/02: mini-ITX en FM2+ pour MSI

- [+] 30/01: APU AMD A8-7600 en test, cTDP, Turb...

- [+] 14/01: Kaveri : AMD A10-7850K et A10-7700K...

- [+] 07/01: CES: AMD en dit plus sur les APU A1...

- [+] 12/11: APU13: Kaveri: TrueAudio, 856 Gflop...