| |

| Radeon RX 460 vs GeForce GTX 1050 / GTX 1050 Ti : le test de cartes Asus, Gigabyte, MSI, Sapphire et Zotac Cartes Graphiques Publié le Mercredi 1er Février 2017 par Damien Triolet URL: /articles/955-1/radeon-rx-460-vs-geforce-gtx-1050-gtx-1050-ti-test-cartes-asus-gigabyte-msi-sapphire-zotac.html Page 1 - Introduction  Nvidia présent sur tous les frontsAlors que nous pensions au départ qu'AMD disposerait d'un petit peu d'espace dans l'entrée de gamme et que Nvidia se focaliserait plutôt sur les cartes graphiques milieu et haut de gamme pour cette première génération de GPU 16/14 nm, il n'en est rien au final. AMD a clairement fait part de son intention de reprendre des parts de marché, notamment avec un petit GPU Polaris 11, mais Nvidia a décidé de ne pas se laisser faire et a probablement accéléré l'arrivée d'un petit GPU Pascal : le GP107. La particularité de ce GP107 est d'être fabriqué en 14 nm, comme les GPU Polaris et contrairement aux autres GPU Pascal qui sont gravés en 16 nm par TSMC. S'ils exploitent un même procédé de fabrication, ils ne sortent cependant pas des mêmes usines, AMD a misé sur son partenaire historique, Global Foundries, alors que Nvidia fait un essai avec Samsung. Ce dernier n'était peut-être pas un acteur attendu dans le monde du GPU, mais c'est bien le coréen qui est à l'origine de cette technologie 14 nm, et qui dispose par conséquent peut être de chaînes de production plus matures. Le GP107 vise un niveau de performances plus élevé que le Polaris 11, principalement grâce à une fréquence de fonctionnement plus élevée. En plus de la GeForce GTX 1050 qui en exploite une version castrée pour s'attaquer à la Radeon RX 460, Nvidia peut ainsi proposer une GeForce GTX 1050 Ti plus performante mais dont le tarif se rapproche de celui des versions premiers prix des cartes du niveau supérieur. Nous allons évidemment observer comment tout ce petit monde se positionne à travers ce dossier. Pour cette première génération 16/14 nm, AMD s'est attaqué au milieu et à l'entrée de gamme avec 2 GPU Polaris. De son côté, Nvidia a décidé de couvrir toutes ses gammes avec pas moins de 5 GPU Pascal. Le GP107 reprend la même architecture Pascal que les GP102 / GP104 /GP106 et vous pourrez retrouver les détails la concernant dans les premières pages du dossier consacré à la GeForce GTX 1080. Il en va de même pour le Polaris 11 qui reprend la même architecture que le Polaris 10 que nous avions décrite lors du test de la Radeon RX 480.  Les GPU Polaris 11 et GP107 sont fabriqués en 14 nm LPP, un process développé par Samsung, qui fabrique le second, et repris par Global Foundries qui fabrique le premier. Après plus de 4 ans de GPU fabriqués en 28 nm chez TSMC, le passage au 16 ou 14 nm représente une évolution significative qui permet de nouveaux compromis plus avantageux en termes de consommation énergétique, de performances et de fonctionnalités. De toute évidence AMD et Nvidia n'ont pas voulu trop attendre pour en faire profiter l'entrée de gamme qui a tendance à évoluer moins vite.  Voici comment se situe les GP107 et Polaris 11 parmi les GPU récents :

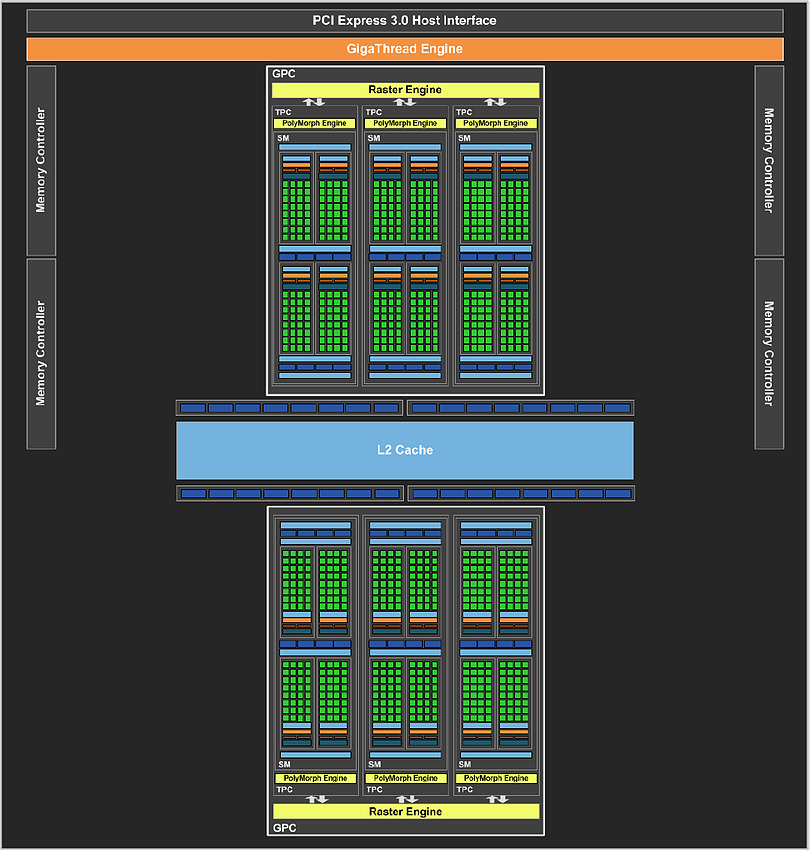

Le GP107 est 10% plus gros que le Polaris 11 et va en toute logique pouvoir viser des performances supérieures. GP107 : le petit PascalPour comprendre l'architecture du GP107, quelques rappels s'imposent concernant la manière dont Nvidia schématise l'organisation interne de ses GPU. A un niveau élevé, ils se composent de un ou plusieurs GPC (Graphics Processing Cluster). Chacun contient un moteur de rastérisation chargé de projeter les primitives et de le découper en pixels. A l'intérieur de ces GPC, nous retrouvons un ou plusieurs TPC (Texture Processor Cluster). Ne vous fiez pas à ce nom, vestige de précédentes architectures, le TPC est aujourd'hui décrit comme la structure qui représente le Polymorph Engine, nom donné à l'ensemble des petites unités fixes dédiées au traitement de la géométrie (chargement des vertices, tessellation etc.). Enfin, au plus bas niveau, ces TPC intègrent un ou plusieurs SM (Streaming Multiprocessor) qui représentent le coeur de l'architecture. C'est à leur niveau que prennent place les unités de calcul (affreusement appelées "CUDA cores" par le marketing), les unités de texturing, les registres ou encore la mémoire partagée utile au GPU computing. Sur base de ces éléments, voici comment est organisé le GP107 dans ses deux versions commerciales :  [ GP107 ] [ GP107 sur GTX 1050 ] Nous pouvons observer que le GP107 intègre 2 GPC, comme le GP106. Ils se contentent par contre de 3 SM contre 5 pour les GPC des autres GPU Pascal. Le nombre d'unité de calcul est donc en retrait de 40% par rapport au GP106. L'interface mémoire a de son côté été limitée à 128-bit et 32 ROP, ce qui représente cette fois 33% de moins mais à peu près 40% de moins si nous prenons en compte sa fréquence. Pour la GeForce GTX 1050, Nvidia a désactivé l'un des 6 SM mais conserve la totalité de l'interface mémoire. A noter que sur les GPU Maxwell et Pascal, le débit de pixel peut être limité par le nombre de SM, ceux-ci ne pouvant transférer que 4 pixels par cycle vers les ROP. Dans le cas du GP107 cela aurait ainsi pu être une limitation mais selon nos mesures, ce n'est pas le cas et il est possible d'atteindre un débit de 32 pixels par cycle et non pas de 24 ou 20. Nvidia a donc visiblement apporté une petite modification. Voici pour comparaisons les spécificités de quelques GPU Nvidia sur 3 générations :

A noter que si le nombre d'unités de calcul n'est pas impressionnant, il ne faut pas oublier qu'avec Pascal Nvidia a particulièrement travaillé sur la fréquence qui fait un bond important. Ses GPU fabriqués en 16nm chez TSMC sont capables d'atteindre 2 GHz, et si le GP107 fabriqué chez Samsung en 14nm se contente plutôt de 1850 ou 1900 MHz, cela reste très élevé. Par ailleurs, chez Nvidia, les unités de calcul généraliste sont épaulées par des unités dédiées aux opérations plus complexes (SFU). Polaris 11 : moins que la moitié d'un Polaris 10Du côté d'AMD, le langage est évidemment différent pour caractériser l'architecture. Nous retrouvons au niveau le plus élevé des Shader Engines (SE). Chacun contient un moteur de rastérisation chargé de projeter les primitives et de le découper en pixels mais également une ou plusieurs partitions de ROP. A l'intérieur de ces SE, nous retrouvons un ou plusieurs CU (Compute Units). C'est à leur niveau que prennent place les unités de calcul organisées en SIMD, les unités de texturing, les registres ou encore la mémoire partagée utile au GPU computing. Sur base de ces éléments, voici comment est organisé le Polaris 11 ainsi que sa version commerciale :  [ Polaris 11 ] [ Polaris 11 sur RX 460 ] Nous pouvons observer que le Polaris 11 intègre 2 SE, soit la moitié du Polaris 10. Chaque SE se contente par contre de 8 CU au lieu de 9, raison pour laquelle Polaris 11 représente moins que la moitié d'un Polaris 10. Son interface mémoire a logiquement été réduite à 128-bit. Assez étrangement, AMD a décidé de ne pas commercialiser de version complète de Polaris 11 pour l'instant. Dans le cadre de la Radeon RX 460, 1 CU par SE est désactivé, ce qui en limite le nombre à 14. Voici pour comparaisons les spécificités des GPU GCN :

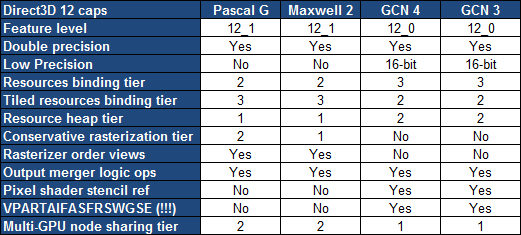

Il est intéressant d'observer que Polaris 11 tel qu'exploité sur la Radeon RX 460 est configuré de manière similaire au GPU Bonaire de la Radeon R7 360.  La GeForce GTX 1050 et la Radeon RX 460 ont toutes deux la particularité d'exploiter un GPU partiellement castré alors que la GTX 1050 Ti profite d'un GPU complet. Les GeForce GTX 1050, GTX 1050 Ti et Radeon RX 460 profitent d'une même bande passante mémoire. Un niveau de la puissance de calcul et de texturing, la RX 460 est similaire à la GTX 1050 Ti. Mais il faut garder en tête que l'efficacité des GeForce est supérieure par rapport à leur puissance de calcul et à leur bande passante mémoire. A noter que le GP107 semble se comporter différemment des autres GPU Pascal au niveau du débit de pixels et de triangles. N'ayant pas pu confirmer cela avec Nvidia nous avons indiqué en italique notre meilleur supposition actuelle. Nous avons ainsi l'impression que ses 2 moteurs de rastérisation travaillent à demi-vitesse, ce qui limite le débit de triangles, alors que le nombre de pixels que chaque SM peut transférer chaque cycle aux ROP aurait été revu à la hausse, de quoi profite d'un fillrate supérieur. Nvidia a opté pour une limite de consommation de référence de 75W pour les GeForce GTX 1050 et GTX 1050 Ti. Sur les autres GeForce cela correspondrait en pratique à une limite de 66W sur le 12V du bus, mais le mécanisme est ici quelque peu différent. En pratique la consommation est limitée à un niveau légèrement inférieur à cela. AMD a de son côté opté pour une limite de consommation ASIC de 48W, ce qui correspond à une consommation totale de 75W pour la RX 460. C'est une limitation importante pour ce GPU qui se voit alors incapable de tourner à sa fréquence maximale même dans les jeux relativement peu lourds. La plupart des partenaires ont donc poussé cette limite et mise en place un connecteur d'alimentation 6 broches pour éviter de trop gros dépassement des normes au niveau du bus. Du côté de la Radeon RX 470, AMD a également recours à un GPU Polaris 10 amputé de quelques unités de calcul. Elle se contente de 32 CU contre 36 pour la version complète de la puce exploitée par la Radeon RX 480. Par rapport à celle-ci, AMD a réduit quelque peu la fréquence maximale, mais bien plus la fréquence de base pour accompagner une réduction importante de la limite de consommation. La Radeon RX 460 et disponibles en versions 2 Go ou 4 Go alors que la GeForce GTX 1050 et GTX 1050 Ti sont exclusivement commercialisées avec respectivement 2 Go et 4 Go. Petite précision qui peut avoir son importance pour certains, le SLI n'est pas supporté sur les GTX 1050, alors que le CrossFire est fonctionnel sur la RX 460. Toujours au niveau des spécifications, nous avons ensuite rassemblé les fonctionnalités exposées à travers Direct3D 12 :  La nouvelle déclinaison de l'architecture GCN introduite avec les RX 400 Polaris n'apporte le support d'aucune nouvelle fonctionnalité de DirectX alors que nous espérions que les Radeon rattrapent les GeForce sur le niveau 12_1. La seule évolution notable par entre les GPU Maxwell 2 et Pascal G concerne un support plus évolué de la rastérisation conservative. Les GPU AMD conservent globalement un avantage avec plus de flexibilité au niveau de la gestion des ressources mais les GeForce Maxwell et Pascal sont les seules à supporter les Volume tiled resources. L'accès aux données entre GPU (en dehors des copies) est également plus flexible en SLI qu'en CrossFire mais cela ne concerne pas les GTX 1050, Nvidia ayant décidé de ne plus supporter le multi-GPU en dehors du haut de gamme (à partir de la GTX 1070).  Pour ce test, nous avions plusieurs Radeon RX 460 à notre disposition. AMD nous a fourni une RX 460 Strix 4 Go d'Asus, Sapphire sa RX 460 Nitro 4 Go et nous avons récupéré un échantillon commercial de la RX 460 2 Go de Gigabyte. Les cartes fournies par AMD et ses partenaires à la presse étaient particulièrement en décalage par rapport à ce qui nous avait été annoncé en termes de tarifs (qui correspondaient à la version 2 Go) et de consommation (la limite de référence limite la fréquence GPU). Il était donc nécessaire de se pencher sur une carte de plus. Asus RX 460 Strix OC 4 Go Pour sa Radeon RX 460 Strix, Asus a opté pour un ventirad basé sur un radiateur simple en aluminium extrudé mais renforcé par 2 caloducs en contact direct et refroidit par 2 ventilateurs. Ceux-ci restent à l'arrêt au repos, la carte est donc totalement silencieuse. En charge par contre nous pouvons entendre des perturbations au niveau du flux d'air, ce qui induit une impression de souffle variable. Sur le plan esthétique, la finition est plutôt de bon niveau et Asus a intégré un logo illuminé par LED RGB contrôlable via son logiciel maison. Un connecteur d'alimentation 6 broches est nécessaire, Asus ayant poussé la consommation de la carte à +/- 105W, et le PCB prévoit 4 phases pour alimenter le GPU. Au niveau de la connectique, nous retrouvons une sortie DVI Dual Link, une sortie HDMI et une sortie DisplayPort. A l'arrière de la carte un connecteur 4 broches FanConnect est prévu pour permettre à la carte graphique de réguler un ventilateur système. Deux variantes sont proposées par Asus, une Strix 4 Go aux fréquences de base et une Strix 4 Go OC dont le GPU est poussé de 1200 à 1236 MHz (+3%). C'est cette dernière qu'AMD nous a fait parvenir et elle est plutôt chère puisqu'il faut compter 165€. A noter que comme à son habitude, Asus tente de tricher sur les échantillons destinés à la presse en forçant un OC automatique de 20 MHz. Nous avons remplacé ce bios presse par un bios commercial. Gigabyte RX 460 WindForce OC 2 Go La Radeon RX 460 WindForce OC de Gigabyte est également basée sur ventirad à base de radiateur simple en aluminium extrudé et refroidit par 2 ventilateurs. Ceux-ci restent à l'arrêt au repos, la carte est donc totalement silencieuse, ce qui est plutôt sympathique pour une carte premier prix. Aucun connecteur d'alimentation n'est nécessaire, Gigabyte se contentant de la limite de consommation de référence de 48W au niveau du GPU, soit +/- 75W pour la carte dans son ensemble. A noter cependant que la consommation 12V va au-delà des 5.5A /66W définit par la norme PCI Express puisque nous avons mesuré 6.15A en charge. Ce dépassement reste léger et n'est pas problématique en pratique. Le PCB prévoit 4 phases pour alimenter le GPU. Au niveau de la connectique, nous retrouvons une sortie DVI Dual Link, une sortie HDMI et une sortie DisplayPort. Des variantes 4 Go et 2 Go de cette carte sont proposées par Gigabyte. C'est cette dernière que nous avons testée. Elle est commercialisée au tarif plancher de 115€. Sapphire RX 460 Nitro OC 4 Go Sapphire a opté pour un système de refroidissement plus complexe que chez ses concurrents pour sa RX 460 Nitro, notamment avec un radiateur à ailettes plus musclé et épaulé par 2 caloducs et un insert en cuivre. Ce radiateur est surmonté par 2 ventilateurs qui ont été prévus pour un remplacement simple et rapide en cas de panne. Ceux-ci restent à l'arrêt au repos, la carte est donc totalement silencieuse. Sapphire a intégré un système de LED bleues qui illuminent l'arrière de la carte à travers une zone translucide du PCB. Celui-ci étant jaunâtre, le résultat donne un logo éclairé en vert. Un connecteur d'alimentation 6 broches est nécessaire, Sapphire ayant poussé la consommation de la carte à +/- 115W, et le PCB prévoit 4 phases pour alimenter le GPU. Au niveau de la connectique, nous retrouvons une sortie DVI Dual Link, une sortie HDMI et une sortie DisplayPort. Une seule variante de la RX 460 Nitro est proposée par Sapphire, elle est overclockée à 1250 MHz (+4%) et équipée de 4 Go de mémoire GDDR5. Il faut compter 150€.  Pour ce test, nous avions également plusieurs GeForce GTX 1050 à notre disposition. Nvidia nous a fait parvenir une GTX 1050 Ti OC de MSI et nous avons récupéré des échantillons commerciaux de la GTX 1050 T(win) OC de MSI et de la GTX 1050 Ti Mini de Zotac. MSI GeForce GTX 1050 T(win) OC 2 Go Pour ses GeForce GTX 1050 et 1050 Ti, MSI a prévu deux designs. Les modèles T pour Twin profitent d'un radiateur en aluminium extrudé plus large et surmonté de 2 ventilateurs. Ceux-ci ne s'arrêtent pas au repos. La coque est composée de 2 structures en plastique fixées l'une contre l'autre pour permettre cette esthétique noir et blanc. Ce type de construction est toujours risqué puisqu'il s'agit de la recette idéale pour générer des bruits de vibrations. Sur l'échantillon testé ce n'était pas le cas aux vitesses de ventilation atteintes lors de nos tests. Aucun connecteur d'alimentation n'est nécessaire, MSI respectant la limite de consommation de référence de 66W au niveau de l'alimentation 12V. Le PCB prévoit 3 phases pour alimenter le GPU et au niveau de la connectique, nous retrouvons une sortie DVI Dual Link, une sortie HDMI et une sortie DisplayPort. MSI décline ce design en versions GTX 1050 2 Go et GTX 1050 Ti 4 Go, c'est la version 1050 2 Go que nous avons testée. Son GPU voit ses fréquences de base et turbo poussées de 1354/1455 à 1404/1518 MHz (+4%). Elle est commercialisée à 135€. MSI GeForce GTX 1050 Ti OC 4 Go Le second design de MSI se contente d'un radiateur en aluminium extrudé plus compact et d'un seul ventilateur qui est cependant plus large. Il ne s'arrête pas au repos. La coque est composée de 2 structures en plastique fixées l'une contre l'autre pour permettre cette esthétique noir et blanc. Ce type de construction est toujours risqué puisqu'il s'agit de la recette idéale pour générer des bruits de vibrations. Et cette fois malheureusement les vibrations étaient bien au rendez-vous. A tel point que la carte était insupportable sur le banc de test et faisait bondir les nuisances sonores à 39 dBA. En glissant quelques petits morceaux de papier entre les 2 morceaux de la coque, ce problème disparait cependant et les nuisances retombent à 30 dBA. Aucun connecteur d'alimentation n'est nécessaire, MSI respectant la limite de consommation de référence de 66W au niveau de l'alimentation 12V. Le PCB prévoit 3 phases pour alimenter le GPU et au niveau de la connectique, nous retrouvons une sortie DVI Dual Link, une sortie HDMI et une sortie DisplayPort. MSI décline ce design en versions GTX 1050 2 Go et GTX 1050 Ti 4 Go, avec et sans OC. C'est la version 1050 Ti 4 Go OC que nous avons testée. Son GPU voit ses fréquences de base et turbo poussées de 1290/1392 à 1341/1455 MHz (+4%). Elle est commercialisée à 175€. Zotac GeForce GTX 1050 Ti Mini 4 Go Pour ses GeForce GTX 1050 Mini, Zotac a opté pour un design minimaliste et très compact (14.5cm). Le ventirad est composé d'un radiateur de type radial en aluminium extrudé et d'un ventilateur. Aucun connecteur d'alimentation n'est nécessaire, Zotac respectant la limite de consommation de référence de 66W au niveau de l'alimentation 12V. Le PCB prévoit 3 phases pour alimenter le GPU et au niveau de la connectique, nous retrouvons une sortie DVI Dual Link, une sortie HDMI et une sortie DisplayPort. Zotac décline ce design en versions GTX 1050 2 Go et GTX 1050 Ti 4 Go. C'est la version 1050 Ti 4 Go que nous avons testée. Son GPU voit ses fréquences de base et turbo poussées de 1290/1392 à 1303/1417 MHz (+1%). Elle est commercialisée à 170€. Pour ce dossier, nous avons repris le protocole utilisé dans les derniers tests, mais en mettant bien entendu à jour l'ensemble des jeux. Toutes les mesures principales ont été faites ou refaites avec les derniers patchs au 23/01/2017, la plupart des jeux étant maintenus à jour via Steam/Origin/Uplay. Nous avons bien entendu installé les pilotes les plus récents également, à savoir les Radeon 17.1.1 et les GeForce 378.49. Par rapport à nos derniers tests de l'été passé, les performances des Radeon et des GeForce ne progressent que très légèrement avec les derniers jeux et patchs. L'exception la plus notable est l'ajout du mode DirectX 12 au jeu The Division qui apporte un gain de +/- 10% aux Radeon. Nous avons opté pour la résolution de 1080p, la plus adaptée à ces cartes graphiques, avec un niveau de qualité moyen à élevé suivant la gourmandise de chaque titre. Bien souvent le MSAA passe à la trappe dans les jeux qui le supportent, pour s'adapter au niveau de performances de ces cartes graphiques d'entrée de gamme. Pour représenter les performances de la Radeon RX 460 de référence, nous avons simplement limité la fréquence GPU de la carte de Gigabyte qui respecte la limite de consommation de référence. Dans le cas des GeForce GTX 1050 et 1050 Ti, nous avons fait de même avec MSI GTX 1050 T OC et avec la Zotac GTX 1050 Ti Mini. Nous avons donc opté également opté pour des solutions de la génération précédente cadencées aux fréquences de référence mais de type personnalisées, c'est-à-dire qui ne sont pas limitées par la température maximale atteinte sur les designs de référence de type turbine. Toutes les cartes ont été testées avec une température ambiante contrôlée à 26 °C et, pour chaque jeu, nous avons pris le temps nécessaire pour que la température et la fréquence GPU se stabilise, ce qui demande de la patience avec certaines cartes graphiques dont l'inertie thermique peut être élevée. Pour rappel, nous avons pu observer avec les derniers pilotes Crimson ReLive un micro gain au niveau de la fréquence lorsque le GPU atteint sa limite de consommation, AMD ayant visiblement revu quelques paramètres de l'algorithme de PowerTune. Nous avons l'impression que ce gain est obtenu par une combinaison de consommation très légèrement supérieure et de tension très légèrement inférieure. Compte tenu des faibles différences, de nombreux tests seraient nécessaires pour confirmer ces impressions. Les tests ont été effectués sur une plateforme X99 avec un Core i7 5960X. Au niveau de l'affichage, nous avons opté pour l'Asus ROG Swift PG278Q mais limité à 120 Hz, certaines Radeon étant capricieuses en 144 Hz avec certains câbles sur ce moniteur. G-Sync était désactivé pour éviter son petit impact sur les performances des GeForce. Configuration de test

Nous avons mesuré les performances lors de l'accès aux textures avec filtrage bilinéaire activé et ce, pour différents formats : en 32 bits classique (8x INT8), en 64 bits "HDR" (4x FP16), en 128 bits (4x FP32), en profondeur de 32 bits (D32F) et en FP10, un format HDR introduit par DirectX 10 qui permet de stocker des textures HDR en 32 bits avec quelques compromis. Les GeForce GTX sont capables de filtrer les textures FP16 à pleine vitesse contrairement aux Radeon, ce qui leur donne un avantage considérable sur ce point. A noter que sur ce point le GPU Polaris 11 est bridé sur la RX 460 puisqu'il ne dispose que de 14/16ème des unités actives. FillrateNous avons mesuré le fillrate sans et puis avec blending, et ce avec différents formats de données : [ Standard ] [ Avec Blending ] Avec ses derniers GPU, qu'il s'agisse de Fiji ou de Polaris P10, AMD n'a pas fait évoluer le nombre de ROP ce qui les place en net retrait par rapport à la concurrence. Il n'y a qu'en HDR 64-bit qu'ils restent équivalents aux GeForce au niveau du fillrate. Ces dernières profitent d'une très haute fréquence GPU pour rentabiliser au maximum leurs ROP. D'après ces mesures, il semble que Nvidia ait modifié quelque peu le design des SM du GP107 de manière à ce que chacun puisque transférer plus de 4 pixels par cycle. C'est la raison pour laquelle le fillrate du GP107 est proche de celui du GP106, tout du moins quand la bande passante ne devient pas limitante. A noter que les GeForce depuis Kepler sont capables de transférer les formats FP10/11 et RGB9E5 à pleine vitesse vers les ROP, comme les Radeon, mais le blending de ces formats se fait toujours à demi vitesse. Par ailleurs, si tous les GPU sont capables de traiter le FP32 simple canal à pleine vitesse sans blending, seules les Radeon conservent ce débit avec blending. Les GeForce traitent le blending en FP32 à une vitesse de 1/8ème alors que ce format est "seulement" 4x plus gros que l'INT8. Par conséquent la limite au niveau du fillrate se transfère à leur niveau, ce qui permet de confirmer, autant en 1x FP32 qu'en 4x FP32, que la GTX 1060 et le GP106 disposent bien de 48 ROP fonctionnels. Étant donné les différences architecturales des GPU récents au niveau du traitement de la géométrie, nous nous sommes évidemment penchés de plus près sur le sujet. Tout d'abord nous avons observé les débits de triangles dans deux cas de figure : quand tous les triangles sont affichés et quand ils sont tous rejetés (parce qu'ils tournent le dos à la caméra) : Notre test atteint de toute évidence ses limites et a du mal à saturer un GPU aussi performant que le GP102 sur le plan du débit maximal de culling. Si les triangles sont affichés, on peut par contre observer qu'il domine largement la discipline. Alors que sur le papier le GP107 est un GPU capable de débiter 2 triangles par cycle comme le GP106, nos tests montrent que ce n'est pas le cas. Soit le schéma d'architecture communiqué par Nvidia n'est pas correct soit les deux moteurs de rastérisation tournent à demi vitesse. Ensuite nous avons effectué un test similaire mais en utilisant la tessellation. A noter que nous avons quelque peu revu notre test de manière à l'adapter à la puissance en hausse des GPU : Les GeForce réaffirment ici leur avantage face aux Radeon qui peuvent se retrouver plus rapidement submergées en cas de génération massive de données ou de hull shaders lourds. Les GeForce profitent d'une architecture qui distribue le traitement géométrique au niveau des SM ainsi que de groupes de threads plus petits (32 vs 64) qui facilitent le maintien d'un taux d'occupation élevé. Avec un débit de triangles limité, le GP107 ne fait cependant pas mieux que le Polaris 11 au niveau de la tessellation. Voici les fréquences que nous avons pu relever en pratique lors de nos mesures de performances :  Du côté des Radeon RX 460, grâce à une limite de consommation nettement relevée par rapport aux spécifications de références, les cartes d'Asus et de Sapphire maintiennent à peu près leur fréquence maximale dans tous les jeux. Ce n'est évidemment pas le cas de la carte de Gigabyte qui se contente d'une moyenne de 93% de sa fréquence maximale. Du côté des GeForce GTX 1050, Nvidia a de toute évidence été très conservateur au niveau de la fréquence turbo officielle. En pratique le GP107 monte beaucoup plus haut et nous obtenons une fréquence moyenne plus de 15% supérieure à ce que communique Nvidia. Un GPU Boost différentLors de nos tests, nous observons toujours le comportement des systèmes de turbo de manière à vérifier quel paramètre impacte le plus les performances des cartes graphiques. Température ? Consommation ? En général, les GTX 1050 Ti qui respectent la limite de référence sont limitées par leur consommation, mais sans impact énorme sur leurs performances. Cette limite est de 75W mais en pratique Nvidia l'applique en général au niveau des sources d'alimentation 12V. La norme PCI Express spécifie une limite de 5.5A via le bus ce qui en fait une limite de 66W auxquels s'ajoutent 1 à 3W issus de la source 3.3V. Nous avons cependant observé que sur GTX 1050 et GTX 1050 Ti, l'algorithme GPU Boost ne se comporte pas comme sur les autres cartes. Il semble limiter la fréquence par rapport à la consommation sans atteindre 100% de l'enveloppe et ce de manière variable suivant la charge. Par ailleurs, nous n'avons pas pu observer les circuits de mesure du courant habituels sur le PCB. De quoi nous laisser supposer que Nvidia a modifié totalement GPU Boot sur le GP107 pour pouvoir déterminer approximativement la consommation à l'aide de mesures internes et d'estimations, comme le fait AMD avec Powertune. D'abord réticent à communiquer sur le sujet, Nvidia nous a finalement répondu ceci : *Our 1050 class GPUs use internal GPU monitors to measure power and regulate GPU Boost. Our GPUs with higher power use a faster and more accurate external hardware current sensor to measure power on each input rail. The primary rationale for this difference is the fact that 1050 class GPUs naturally are lower power, so even overclocked power is still comfortably below all input rail limits This allows us to be slightly less accurate in our power modulation without risk of violating any power connector limits. This in turn allows us to save cost and improve the product.* La consommation est donc bien déterminée à l'aide de mesures internes. Sans nous en dire plus sur le fonctionnement exact, Nvidia précise avoir opté pour cette approche qui permet de réduire les coûts (du PCB) alors que la très faible consommation de son GPU s'accommode sans problème de la précision inférieure. Selon nos tests, certes limités à 3 échantillons, cela fonctionne plus tôt très bien. Et nous avons par ailleurs l'impression que l'algorithme de Nvidia surestime la consommation, ce qui réduit la consommation effective des GTX 1050, alors qu'AMD a plutôt tendance à la sous-estimer (ce qui entraîne des dépassements par rapport aux limites communiquées). OverclockingPour ce dossier, nous n'avons pas effectué de mesures de performances après overclocking, mais nous avons cependant cherché à savoir ce dont étaient capables toutes ces cartes graphiques. Voici ce que nous avons obtenu :  C'est du côté des GeForce GTX 1050 que les gains sont les plus élevés. Et ils le seront de toute évidence également en pratique. Rappelons que l'overclocking GPU des GeForce se fait via un offset qui revient à déplacer la courbe des fréquences/tensions et donc à réduire la tension à chaque niveau de fréquence donné, ce qui se traduit par un gain même quand le GPU atteint sa limite de consommation à ses fréquences de base. C'est différent pour les Radeon pour lesquelles l'overclocking GPU revient à prolonger cette courbe des fréquences/tensions avec dans certains cas une augmentation de la tension automatique à la fréquence overclockée, ce qui se traduit par une absence totale de gain lorsque la limite de consommation est atteinte aux fréquences de base. En réalité le comportement de l'overclocking GPU des Radeon se rapproche plus de l'overvolting accessible sur certaines GeForce ! Notons qu'il n'est pas possible de pousser la limite de consommation sur les GeForce GTX 1050 sans connecteur d'alimentation. Celles-ci exploitent déjà la consommation maximale autorisée via le bus et Nvidia n'autorise pas ses partenaires à ne pas respecter cette spécification. Cette limite peut par contre être relevée sur les Radeon, y compris sur la carte de Gigabyte sans connecteur d'alimentation que nous avons testée, quitte à aller au-delà des spécifications. Enfin, dans le cas de certaines Radeon RX 460, notamment Sapphire et Asus, il existe des bios qui permettent d'activer les 2 CU supplémentaires présents dans le GPU. Rien ne garantis cependant qu'ils seront fonctionnels sur toutes les cartes. Par ailleurs, ces bios ne sont pas fonctionnels avec les pilotes les plus récents. Nous avons utilisé le protocole de test qui nous permet de mesurer la consommation de la carte graphique seule. Nous avons effectué ces mesures au repos sur le bureau Windows 10 et en veille écran. Pour la charge, nous testons d'une part Battlefield 4 en mode Ultra qui représente un jeu moyennement lourd et d'autre part The Witcher 3 pour représenter un jeu très lourd. La consommation au repos des GeForce GTX 10 tranche avec celle des Radeon RX 400. Pour rappel au lancement de la Radeon RX 480, AMD nous avait indiqué qu'il s'agissait d'un bug des premiers pilotes et que cela serait rapidement corrigé. Il n'y a eu aucune amélioration notable depuis. En charge, les GTX 1050 et GTX 1050 Ti affichent une consommation maximale de +/- 60W. Elles sont limitées par leur consommation dans la plupart des cas mais tournent malgré tout à une fréquence GPU qui est toujours largement supérieure à celle annoncée par Nvidia qui a été très conservateur. Du côté des Radeon RX 460, la consommation en charge est supérieure. Dans le cas de la carte de Giagbyte, qui respecte les spécifications de référence sur ce point, soit 48W de consommation ASIC, la carte consomme à peu près 75W. Elle est alors plutôt limitée au niveau de sa fréquence GPU maintenue en jeu. Par ailleurs, sa consommation 12V va au-delà des 5.5A /66W définit par la norme PCI Express puisque nous avons mesuré 6.15A en charge. Ce dépassement reste léger et n'est pas problématique en pratique. Asus et Sapphire ont opté pour une limite de consommation revue à la hausse, 72W pour l'ASIC soit plus de 100W pour la carte dans son ensemble. Cela permet par contre de maintenir en permanence la fréquence maximale en jeu. Bien que ces données soient approximatives, compte tenu de la variation entre échantillons d'un même modèle, nous avons mis en relation ces mesures de consommation avec les performances, en retenant des fps par 100W pour que les données soient plus lisibles, de quoi donner une idée globale sur le rendement énergétique de toutes ces cartes : [ Battlefield 4 ] [ The Witcher 3 ] Entre Pascal et Maxwell, Nvidia est parvenu à faire progresser le rendement énergétique plus que ne l'a fait AMD avec ses GPU Polaris, même si ceux-ci font mieux que la génération précédente. Les GeForce Pascal se démarquent particulièrement dans Battlefield 4, qui fait un usage plus intensif de l'interface mémoire, que nous pouvons supposer plus efficace du côté de Nvidia. A noter que plus une carte graphique est limitée par sa consommation, plus son rendement tend à être élevé. Un phénomène lié au fait que la baisse de fréquence est associée à une baisse de tension qui a un impact plus que proportionnel sur la consommation. C'est la raison pour laquelle les GTX 1050 Ti ainsi que la RX 460 de Gigabyte ont un rendement plus élevé. Nous plaçons les cartes dans un boîtier Cooler Master RC-690 II Advanced et mesurons le bruit d'une part au repos et d'autre part en charge sous le test1 de 3DMark11. Un SSD est utilisé et tous les ventilateurs du boîtier ainsi que celui du CPU sont coupés pour la mesure. Le sonomètre est placé à 60cm du boîtier fermé et le niveau de bruit ambiant se situe à moins de 20 dBA, ce qui est la limite de sensibilité pour laquelle il est certifié et calibré. Au repos, les RX 460 testées ici ont un net avantages puisqu'elles arrêtent toutes leurs ventilateurs contrairement aux GeForce GTX 1050 et GTX 1050 Ti bon marché. Nous pouvons supposer qu'AMD a ici fait en sorte de réduire les coûts d'implémentation de cette fonctionnalité pour faciliter sa généralisation. En charge c'est la RX 460 de Gigabyte qui s'en tire le mieux, ses ventilateurs étant à peine audibles. Les autres solutions affichent en général +/- 30 dbA, à l'exception de la 1050 Ti OC de MSI dont le design de la coque génère d'énormes vibrations, y compris au repos ! TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne : Avec des ventilateurs à l'arrêt, la température GPU des RX 460 est forcément plus élevée que celle des GeForce au repos, mais ce n'est pas un soucis. En charge, nous pouvons observer que la GTX 1050 Ti de Zotac est plutôt très bien refroidie, de quoi penser que sa courbe de ventilation aurait pu être modifiée pour réduire les nuisances sonores. Alors que la RX 460 Nitro dispose d'un ventirad bien plus musclé que celui des autres cartes, ses performances au niveau du refroidissement n'ont rien d'exceptionnel.  Nous lançons le test Fire Strike avec les presets standard et extrême proposés par Futuremark. Le mode ultra passe à la trappe, n'apportant pas réellement d'information utile de plus par rapport au mode extrême. A la place nous intégrons le nouveau Time Spy. A noter qu'avec les dernières mises à jour de 3DMark, les performances augmentent très légèrement, en bug les ayant limitées quelque peu cet été. [ Fire Strike ] [ Fire Strike Extreme ] Dans Fire Strike standard, les GTX 1050 ont l'avantage sur les RX 460 et l'écart se creuse dans Fire Strike Extreme. 3DMark Time SpyNous lançons ensuite le nouveau test Time Spy qui exploite l'API Direct3D 12 : Dans Time Spy, les Radeon RX 460 profitent d'une meilleure prise en charge du multi engine et de l'exécution concomitante des tâches ("async compute") pour se rapprocher des GTX 1050.  Après plusieurs années de bons et loyaux services, notamment en matière de mesure de la consommation, nous avons mis Anno 2070 à la retraite. Il est remplacé par Anno 2205, un peu plus lourd graphiquement mais moins gourmand énergétiquement. Nous utilisons le mode de qualité élevée du jeu mais en MSAA 2x et effectuons un déplacement sur une carte en mesurant les performances avec Fraps. Le jeu est maintenu à jour via Uplay. Dans ce premier jeu testé, les GeForce ont un très large avantage et la RX 460 fait à peine mieux que la GTX 750 Ti.  Ashes of the Singularity est un des premiers jeux DirectX 12 disponible. Il a la particularité d'être conçu en terme de gameplay pour ces nouvelles API avec des scènes très lourdes qui ont besoin d'un surcoût réduit des commandes de rendu ainsi que d'une bonne exploitation des CPU multicoeurs. Par ailleurs, AotS intègre un support du multi engine destiné à booster les performances GPU, ce qu'AMD appelle Async Compute. Cette option apporte des gains sur les Radeon mais est contreproductive ou n'a pas d'effet sur les GeForce, y compris sur la GTX 10x0. Nous avons utilisé la configuration par défaut du jeu qui active Async Compute sur Radeon et le désactive sur GeForce car contreproductif. Nous utilisons une partie du benchmark intégré avec un niveau de qualité Low, sans MSAA et en mode DirectX 12. Le jeu est maintenu à jour via Steam. Les Radeon s'en tirent bien mieux dans ce jeu où la RX 460 de base est au niveau de la GTX 1050 alors que les RX 460 Asus et Sapphire sont au niveau de la GTX 1050 Ti.  Battlefield 4 repose sur le moteur Frostbite 3, une évolution de la version 2 présente dans Battlefield 3. La base du rendu reste très proche (rendu différé, calcul de l'éclairage via compute shaders) et les évolutions visibles sont mineures, DICE ayant principalement optimisé son moteur pour les consoles de nouvelle génération. Parmi les petites nouveautés, citons un support plus avancé de la tessellation et une amélioration du module "destruction" du moteur. Sur PC, un mode Mantle spécifique aux Radeon et qui permet de réduire le coût CPU du rendu est proposé mais nous ne l'avons pas utilisé pour ce test. Pour rappel, il s'agit d'une API propriétaire de plus bas niveau dédiée aux Radeon HD 7000 et supérieures, qui a été développée par AMD et DICE. Depuis l'arrivée d'autres API de bas niveau, AMD a cependant cessé les développements autour de Mantle et n'a pas optimisé son utilisation dans les pilotes pour ses derniers GPU. Nous testons le mode Ultra sans MSAA et nous relevons les performances avec Fraps, sur un parcours bien défini. Le jeu est maintenu à jour via Origin. Les GeForce sont devenues nettement plus efficaces que les Radeon sous le Frosbite Engine de toute évidence même sans MSAA, le travail de Nvidia sur l'efficacité de son architecture étant particulièrement payant dans ce jeu.  Crysis 3 reprend le même moteur que Crysis 2 : le CryEngine 3. Ce dernier profite cependant de quelques petites évolutions telles qu'un support plus avancé de l'antialiasing : FXAA, MSAA et TXAA sont au programme, tout comme un nouveau mode appelé SMAA. Il s'agit d'une évolution du MLAA qui permet, optionnellement, de prendre en compte des données de type sous-pixels soit à travers la combinaison avec du MSAA 2x, soit avec une composante temporelle calculée à partir de l'image précédente. Le SMAA 1x est la simple évolution du MLAA, le SMAA 2tx utilise une composante temporelle relativement complexe et le SMAA 4x y ajoute le MSAA 2x. Notez qu'il ne faut pas confondre le SMAA 2tx proposé en mono-GPU avec le SMAA 2x proposé en multi-GPU, ce dernier utilisant du MSAA 2x sans composante temporelle. Nous mesurons les performances avec Fraps en qualité moyenne avec SMAA 2tx. Le jeu est maintenu à jour via Origin. La GTX 1050 est ici plus de 30% plus performant que la RX 460, une tendance qui va se retrouver en moyenne.  Après une longue période en version beta, DiRT Rally est finalement sorti en version finale fin 2015. Il vient logiquement remplacer GRID 2 dans notre panel de test. Nous mesurons les performances avec Fraps sur une scène de test personnalisée qui inclut l'éclairage de nuit ainsi qu'une forte pluie. L'advanced blending qui pose soucis aux Radeon n'est pas activé mais le MSAA 2x est de la partie. Le jeu est maintenu à jour via Steam. Les Radeon restent en retrait, souffrant probablement d'un débit de pixels plus réduit et/ou d'une moins bonne exploitation de leur bande passante mémoire.  La nouvelle mouture de DOOM conserve la tradition d'un moteur graphique OpenGL mais vient de recevoir en option un moteur Vulkan. Une API qui fait donc son apparition dans notre suite de test. Le jeu n'est pas extrêmement gourmand, mais il est plutôt bien optimisé et atteint facilement 150 à 200 fps sur notre Core i7-5960X poussé à 4 GHz. Nous mesurons les performances avec Fraps sur un parcours bien défini. Le jeu est maintenu à jour via Steam et nous utilisons le mode de qualité élevée avec SMAA. Le mode Vulkan affiche un mini gain sur les GeForce mais un gain conséquent sur les Radeon par rapport au mode OpenGL. Par contre avec la dernière version du jeu et/ou des pilotes, il refuse de se lancer en mode Vulkan sur les cartes graphiques équipées de moins de 4 Go de mémoire. Nous n'avons donc utilisé Vulkan que sur les cartes 4 Go, et OpenGL sur les autres. Lorsque la version Vulkan du moteur peut être activée, les performances profitent d'un bon petit coup de boost. L'écart est particulièrement criant entre les RX 460 4 Go et 2 Go, ces dernières étant en partie limitées par leurs 2 Go de mémoire, même en OpenGL. Avec seulement 2 Go, les GeForce souffrent moins.  Dying Light est un jeu de type survival horror animé par le Chrome Engine 6 de Techland et dans lequel le monde est plutôt vaste et ouvert. Nvidia a travaillé avec Techland pour y inclure certains effets issus de ses librairies Gameworks tels que le HBAO+ et le Depth of Field. Nous avons mesuré les performances avec Fraps sur un parcours bien défini en qualité moyenne et sans les effets Gameworks. Le jeu est maintenu à jour à travers Steam. Les GeForce sont plus à l'aise que les Radeon dans ce jeu mais il reste proche de la moyenne.  Fallout 4 repose sur une version améliorée du Creation Engine introduit avec Skyrim et développé en interne par Bethesda. Un moteur qui permet de pousser la qualité graphique vers le haut par rapport au Gamebryo exploité pour les jeux de la génération précédente dont faisait partie Fallout 3. Dans la version qui équipe Fallout 4, l'éclairage gagne en réalisme notamment avec le passage au physically-based deferred renderer et l'ajout d'une composante volumétrique pour représenter l'atmosphère. La version la plus évoluée de cet effet a été développée en collaboration avec Nvidia et fait appel à la tessellation. Par défaut AMD réduit le niveau de tessellation et donc potentiellement la qualité graphique via ses pilotes. Une option que nous avons cependant désactivé. Au niveau de l'antialiasing les options proposées sont par contre assez pauvres avec au mieux un Temporal AA qui fonctionne plutôt bien mais uniquement en mouvement constant. A l'arrêt ce type d'antialiasing est évidemment limité dans son action. Nous testons Fallout 4 avec Fraps sur un parcours bien défini en poussant les options au niveau Medium. Le jeu est maintenu à jour via Steam. La GTX 1050 a un avantage d'un peu plus de 30% sur la RX 460, ce qui correspond à la moyenne que nous avons observé.  Dernier opus de la série, Far Cry Primal nous envoie chasser le mammouth dans la préhistoire. Il est graphiquement similaire à Far Cry 4 même si son moteur graphique a reçu quelques petites améliorations. Nous activons le niveau de qualité normale du jeu avec sans antialiasing. Nous utilisons Fraps sur un parcours bien défini et le jeu est maintenu à jour via Uplay. Les Radeon s'en tire un peu mieux dans ce jeu, mais c'est insuffisant pour que la RX 460 puisse lutter face à la GTX 1050.  Enfin, après de nombreuses demandes, nous avons ajouté GTA V à notre protocole de test. Plutôt gourmand du côté des GPU, il propose de nombreuses options graphiques. Nous testons le jeu avec Fraps en qualité élevée sans FXAA. Le jeu est maintenu à jour via Steam. Les Radeon sont très en retrait dans ce jeu.  Cette dernière mouture d'Hitman, proposée sous la forme d'épisodes, a la particularité de supporter DirectX 12, mode qui est devenu légèrement plus performant avec les derniers patchs et pilotes, autant pour les Radeon que pour les GeForce. Nous l'avons donc préféré au mode DirectX 11, tout du moins pour les cartes équipées d'au moins 3 Go. Sur les cartes 2 Go, les saccades sont récurrentes et les performances varient de légèrement inférieures à nettement inférieures sur RX 460 (32 vs 43 fps!). Nous sommes donc passés sur le mode DirectX 11 pour les cartes 2 Go. Pour mesurer les performances, nous poussons les options graphiques au niveau Ultra et utilisons Fraps dans le jeu maintenu à jour via Steam. C'est l'un des jeux dans lequels les Radeon sont le plus en forme… tout du moins quand elles sont équipées de 4 Go !  Project Cars est un jeu de course automobile développé depuis 2011 sur base d'un système de beta participative qui permettait d'accéder aux nouvelles builds régulières et d'interagir avec les développeurs de Slightlymad Studios (à l'origine des Need For Speed Shift). Son moteur au rendu différé supporte DirectX 11 et c'est ce mode que nous avons testé en poussant toutes les options au niveau élevé sans MSAA. Nous avons testé le jeu via Fraps sur un parcours bien défini et avec de la pluie au niveau des conditions météo. Un détail important à préciser puisqu'il réduit significativement les performances. Nous avons opté pour 7 concurrents qui restent devant nous pendant la mesure des performances. Les Radeon ont beaucoup de mal dans ce jeu, ce n'est pas nouveau. Critiqué pour avoir favorisé Nvidia, le développeur s'est justifié en expliquant que ce n'était pas du tout le cas, mais qu'AMD n'avait pas voulu collaborer en amont de la sortie du jeu pour s'assurer d'optimiser les performances. Difficile de savoir ce qu'il s'est réellement passé, mais si AMD a progressivement introduit quelques optimisations spécifiques dans ses pilotes, elles sont nettement insuffisantes pour revenir au niveau de ce que propose Nvidia. Sans MSAA, l'écart entre Radeon et GeForce est proche de la moyenne.  Le précédent Tomb Raider était déjà plutôt réussi graphiquement, et le nouveau titre va encore plus loin. Une vraie réussite qui se traduit par une gourmandise qui peut être élevée. Les développeurs ont cette fois travaillé avec Nvidia et proposent la première implémentation du VXAO, une technique de calcul de l'occultation ambiante dérivée du VXGI spécifique aux GPU Maxwell et Pascal. Bien que le jeu supporte DirectX 12, ce mode est moins performant autant avec les Radeon qu'avec les GeForce. Nous nous contentons donc du mode DirectX 11. Nous poussons la qualité en mode Medium sans AA et mesurons les performances sur un parcours bien défini avec Fraps. Le jeu est maintenu à jour via Steam. Les Radeon font ici un petit mieux que la moyenne mais c'est très insuffisant pour que la RX 460 puisse lutter avec la GTX 1050.  Développé par EA DICE, Star Wars Battlefront exploite comme vous vous en doutez le moteur maison Frostbite 3 qui a été introduit avec Battlefield 4. Il s'en distingue cependant par quelques petites améliorations graphiques au niveau de la tessellation pour ajouter des détails aux terrains et de l'éclairage qui gagne en réalisme et profite d'un effet d'occultation ambiante à base de compute shaders plus évolués. Star Wars Battlefront fait par contre totalement l'impasse sur le support du MSAA et se contente du FXAA ou du TAA, qui, une fois encore, se comporte plutôt bien mais uniquement lorsque les mouvements sont suffisants. Nous testons le jeu en qualité élevée, avec Fraps sur un parcours bien défini et il est maintenu à jour via Origin. Les Radeon se positionnement plutôt bien dans ce jeu mais cela reste insuffisant pour la RX 460.  The Division a reçu il y a peu un patch qui propose un mode DirectX 12. Ce dernier est plus performant sur les Radeon, qui gagnent +/- 10%, alors qu'il est plus lent sur les GeForce qui perdent à peu près 5%. Etant donné que la qualité graphique ne change pas, nous avons activé le mode DirectX 12 sur Radeon et le mode DirectX 11 sur GeForce. Nous testons le jeu en qualité moyenne mais en réduisant la qualité des ombres. Etant donné le cycle jour / nuit qui impacte les performances, nous devons utiliser le bench intégré. Nous n'utilisons cependant pas le score qu'il produit mais activons Fraps sur la partie du parcours qui correspond aux scènes de jeu, le benchmark ayant tendance à surévaluer les performances via des passages plus légers. Le jeu est maintenu à jour via Uplay. Grâce au mode DirectX 12, c'est le jeu dans lequel les Radeon RX 460 se comportent le mieux mais les GTX 1050 conservent une petite avance.  Très attendu, le dernier opus de The Witcher ne déçoit pas. Développé par CD Projekt RED, il repose sur le REDengine 3, un moteur conçu pour gérer de vastes mondes ouverts, raison pour laquelle il tourne exclusivement en 64-bit. CD Projekt RED s'est associé à Nvidia pour intégrer deux effets gaphique de la suite Gameworks : le HBAO+ et surtout HairWorks. Réponse au TressFX d'AMD, HairWorks améliore la chevelure des personnages, la crinière des chevaux et la fourrure de plusieurs animaux ou créatures rencontrés dans le jeu en faisant appel à un niveau de tessellation très élevé pour chaque brindille. HairWorks est donc très gourmand et Nvidia aurait fait en sorte que son implémentation complique le travail d'optimisation d'AMD, ce qui n'a pas manqué de créer la polémique, même si en pratique désactiver cet effet ne dénature pas vraiment le jeu. Nous l'avons d'ailleurs testé sans HairWorks et sans HBAO+ de manière à atteindre un niveau de performances adapté. Nous effectuons un parcours bien défini avec Fraps. L'écart entre les RX 460 et les GTX 1050 est ici pile dans la moyenne avec un peu plus de 30%. Bien que les résultats de chaque jeu aient tous un intérêt, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats et en attachant une importance particulière à donner le même poids à chacun des jeux. Nous avons attribué un indice de 100 à la Radeon RX 460 2 Go aux spécifications de référence : Aux spécifications de référence, ou pour des modèles premiers prix, la GeForce GTX 1050 2 Go l'emporte très largement sur la Radeon RX 460 2 Go avec une avance d'un peu plus de 30%. Les variantes 4 Go, overclockées et à la limite de consommation nettement relevée telles que les RX 460 d'Asus et de Sapphire ne peuvent rattraper qu'un peu plus de 10% de ce retard. Un petit bond que font également les GTX 1050 Ti 4 Go. Nvidia l'emporte donc assez facilement sur le plan des performances. Par rapport aux cartes de la génération précédente, la RX 460 fait un tout petit peu moins bien que la R7 370 basée pour rappel sur un très vieux GPU GCN introduit avec la HD 7850. C'est cependant près de 30% de mieux que la R7 360. Du côté des GeForce, les GTX 1050 et 1050 Ti font à peu près 10% de mieux que les GTX 950 et 960. Un bond qui passe à plus de 50% par rapport à la GTX 750 Ti. Il est également intéressant de noter l'écart relativement important avec les cartes graphiques de la catégorie supérieure. Une GTX 1060 3 Go basique est ainsi 50% plus performante qu'une GTX 1050 Ti et 70% plus performante qu'une GTX 1050. Du côté des Radeon, une RX 470 sera à peu près 2x plus performante qu'une RX 460 ! Initialement introduit dans le cadre de la VR, le Multi-Resolution Shading est une technique de rendu qui consiste à réduire la résolution en périphérie de manière à améliorer les performances. Lors de la GDC 2016, Nvidia avait annoncé son intention de la rendre disponible également en dehors de la VR, notamment pour aider les cartes graphiques d'entrée de gamme. Dans ce contexte, le MRS permet de maintenir une qualité plus élevée au centre de l'image, là où le regarde du joueur se concentre dans certains types de jeux tels que les FPS. De quoi pouvoir éventuellement proposer un compromis intéressant au niveau des options graphiques.  Le problème du MRS est qu'il doit être implémenté par les développeurs directement au niveau du moteur de jeu. Nvidia ne peut pas simplement le forcer via ses pilotes. Le premier et seul jeu à l'implémenter est Shadow Warrior 2. Le jeu propose des versions conservatrice et agressive de l'algorithme de Nvidia :  Qu'est-ce que cela donne en pratique ? Voici des extraits en pleine résolution du coin supérieur droit de screenshots pris en 1080p :  [ Rendu classique ] [ MRS Conservative ] [ MRS Aggressive ] La version conservatrice du MRS n'est pas si simple que cela à discerner alors que la réduction de résolution est plus évidente en version agressive. En phase de jeu par contre cela passe plutôt inaperçu en ce qui nous concerne, excepté quand un effet de bloom prononcé se retrouve appliqué au niveau de l'épée. Il y a probablement à ce sujet des possibilités de mieux exploiter la technique pour ne l'appliquer qu'à certaines passes de rendu et en traiter d'autres tels que certains effets de post traitement en pleine résolution. Quel est l'impact sur les performances ? Sur notre test rapide, la version conservatrice du MRS permet de gagner 4% et la version agressive 13%. Des gains qui sont donc limités, probablement parce que la prise en charge du rendu en résolution multiple a un surcoût à prendre en compte. Pour réellement intéresser les développeurs, cette approche de Nvidia devrait selon permettre d'obtenir des gains plutôt de l'ordre de 25%. A voir si le MRS pourra faire mieux dans d'autres titres mais en attendant l'intérêt reste limité et n'est pas un argument décisif en faveur des GeForce GTX 1050. Lors du test des Radeon RX 470 et GeForce GTX 1060 3 Go, nous avions donné l'avantage à la première malgré un déficit de performances, d'autres arguments jouant en sa faveur tels que la présence de 4 Go de mémoire, l'avantage compétitif de FreeSync ou encore le meilleur comportement dans les jeux DirectX 12 ou Vulkan. En est-il de même pour la Radeon RX 460 ? Pas vraiment. Si l'avantage de la GTX 1060 3 Go n'était que de 8% sur la RX 470, il fait un bond à plus de 30% entre la GTX 1050 et la RX 460. Trop peu. C'est ainsi que se résumerait notre première impression si nous devions résumer en deux mots la prestation de la RX 460, qui doit se contenter d'un GPU castré et fortement limité par sa consommation. Heureusement pour AMD la version longue est un peu moins tranchante mais reste malgré tout à l'avantage de Nvidia.  Les RX 460 premiers prix, qui se contentent de 2 Go, se négocient à 115€ alors qu'il faut compter 130€ pour les GTX 1050, également équipées de 2 Go de mémoire vidéo. Un tarif auquel vous pourrez trouver les premières RX 460 4 Go, mais pour l'instant, en dehors des quelques jeux à l'étroit avec 2 Go, elles n'amélioreront pas les performances. Quant aux RX 460 4 Go plus musclées, elles sont bien plus chères, comptez 150€ pour la Sapphire Nitro ou encore 165€ pour l'Asus Strix. Un tarif qui se rapproche de celui des premières GTX 1050 Ti 4 Go, qui profitent d'un GPU complet pour donner un coup de boost supplémentaire aux performances. A 165€, leur positionnement est à mi-chemin entre leurs petites soeurs et les cartes graphiques de la catégorie supérieure, alors que leurs performances en restent loin. A toutes ces observations tarifaires, il faut en ajouter une sur la quantité de mémoire vidéo et les nouvelles API graphiques. 2 Go de mémoire ne nous semble en effet pas suffisant pour pouvoir profiter de ces API et des gains de performances qu'elles peuvent apporter. Les développeurs ont du mal à mettre en place des mécanismes aussi efficaces que ceux des pilotes pour les API précédentes pour gérer les dépassements de mémoire avec un impact aussi réduit que possible. Dans la plupart des premiers jeux qui les exploitent, nous observons que les modes DirectX 12 ou Vulkan entrainent plantages, saccades ou baisse de performances par rapport aux modes DirectX 11 ou OpenGL lorsque les cartes graphiques sont limitées à 2 Go. Certes dans certains cas il est possible de s'en sortir en réduisant la qualité des textures par exemple, mais le rendu visuel perd alors beaucoup. Enfin, il est important de noter que les Radeon RX 460 et les GeForce GTX 1050 / 1050 Ti permettent de jouer plutôt confortablement en 1080p, avec bien entendu un niveau de qualité graphique variable suivant leurs performances.  Après avoir pris tout ceci en compte, la référence qui nous semble offrir le meilleur compromis (ou le moins mauvais, c'est selon) dans l'entrée de gamme est la GeForce GTX 1050 2 Go "basique". C'est celle qui vous permettra de profiter des jeux actuels dans les meilleures conditions. Mais il faut noter qu'il ne s'agit pas d'une solution qui aura une longue durée de vie, ses 2 Go pourront devenir un problème à plus ou moins long terme (1 an ?). Vient ensuite la Radeon RX 460 4 Go "basique", qui permet d'avoir l'esprit tranquille par rapport à la quantité de mémoire mais qui reste nettement moins performante. Un déficit qui pourra être en partie compensé au niveau du ressenti si vous optez pour un écran FreeSync. Enfin, les GeForce GTX 1050 Ti 4 Go, un peu plus chères permettent de combiner le niveau de performances supérieur à une longévité supérieure. Si nous insistons sur le mot "basique" dans cette conclusion, c'est parce que les modèles plus musclés ont particulièrement peu d'intérêt pour ces cartes graphiques d'entrée de gamme compte tenu du surcoût qu'elles engendrent alors que la faible consommation des modèles basiques en fait des cartes qui sont déjà relativement discrètes. Avec une mention spéciale à la RX 460 WindForce de Gigabyte sur ce point ! Copyright © 1997-2025 HardWare.fr. Tous droits réservés. |